Mac向けのSPICEとしてMacSpiceというものがあるが、これが結構良かったので使い方を簡単にまとめたい。

題材として今回はローパスフィルタ回路のシミュレーションをする。

題材

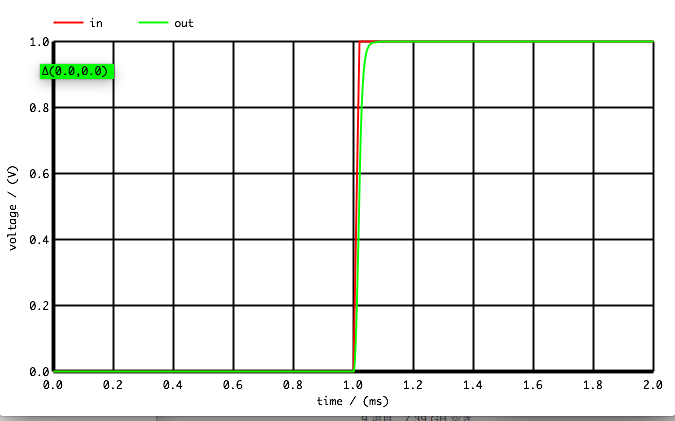

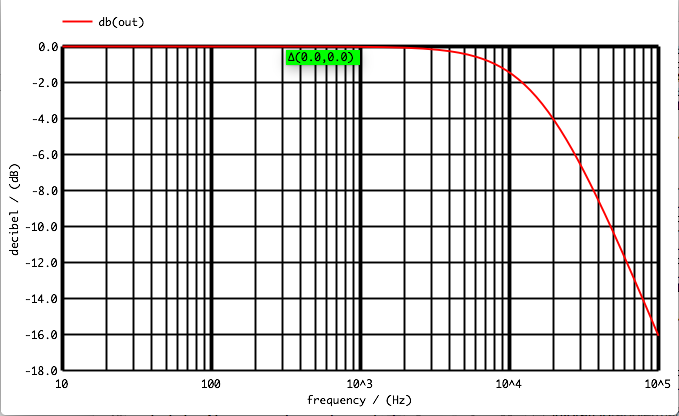

今回はローパスフィルタ回路として、単純なRC回路とRLC回路を対象に、周波数特性とステップ入力時の動きをシミュレーションする。

回路記述

まずはSPICE用に回路を記述する。

題材用に書いた回路記述は以下。これを「lpf.CIR」として保存する。

ローパスフィルタ評価用 *** circuit definition ** RC LPF R0 in out 20 C0 out 0 500n ** RLC LPF * R0 in X 20 * L0 X out 22uH * C0 out 0 500n ** Vin Vin in 0 DC 0.0 AC 1.0 0.0 PULSE( 0.0 1.0 1ms ) *** sim commands .control * AC analysis ac dec 50 10Hz 100kHz echo "$curplot:AC analysis" * transient analysis tran 20us 2ms 0ms 20us echo "$curplot:transient analysis" .endc .END

手動になるが、シミュレート時は冒頭の方の「** RC LPF」と「** RLC LPF」のコメントアウトを修正してRC回路かLRC回路かを切り替える。

シミュレーション

以下のコマンドを実行すると、シミューレーションを実行し、結果をグラフとして表示する。

source lpf.CIR 【結果が出力される】 setplot 【AC analysisと表示されたグラフ名ac*を入力】 plot db(out) setplot 【transient analysisと表示されたグラフ名tran*を入力】

結果

RC回路

RLC回路